AIによる画像解析技術は、私たちの生活やビジネスに大きな変革をもたらしています。その中でも、特に高度な画像理解を可能にする技術として「セマンティックセグメンテーション」が注目を集めています。この技術は、単に画像に何が写っているかを認識するだけでなく、画像のピクセル一つひとつが「何」であるかを緻密に識別します。たとえば、自動運転車が周囲の「道路」「歩行者」「他の車両」をピクセルレベルで正確に区別できるのは、この技術のおかげです。本記事では、セマンティックセグメンテーションの基礎的な概念から、物体検出などの関連技術との違い、ビジネスを加速させる具体的な活用事例、そして最新のアルゴリズムや将来の展望まで、幅広くかつ深く解説します。この技術がもたらす価値と、画像解析の未来を共に探っていきましょう。

セマンティックセグメンテーションとは?基礎概念と関連タスクを整理

セマンティックセグメンテーションは、現代のAI画像解析において中心的な役割を担う技術です。ここでは、その基本的な定義から、混同されがちな他の画像認識タスクとの違い、ビジネスにおける価値、そして性能を測るための主要な指標や学習に用いるデータセットまで、基礎となる知識を体系的に整理します。

セマンティックセグメンテーションの定義とピクセル単位分類の意義

セマンティックセグメンテーションとは、画像を構成する全てのピクセルに対して、それが属するクラス(例:空、道路、建物、人物など)を予測し、ラベル付けする技術です。リンゴの画像があれば、画像全体を「リンゴ」と認識するのではなく、リンゴの部分のピクセルだけを「リンゴ」クラスに、背景のピクセルを「背景」クラスに塗り分けるイメージです。このピクセル単位での精密な分類こそが、本技術の最大の特徴であり、単なる物体検出よりもはるかに詳細なシーン理解を実現します。こうした緻密な理解は、周囲の環境を正確に把握する必要がある自動運転や、微細な異常を見つけ出す医療画像診断など、高度な判断が求められる領域で不可欠なものとなっています。

物体検出・インスタンス/パノプティックセグメンテーションとの違い

画像認識には、セマンティックセグメンテーション以外にも類似したタスクが存在します。物体検出(Object Detection)は、画像内の物体の位置を矩形(バウンディングボックス)で囲み、そのクラスを特定する技術です。一方、セマンティックセグメンテーションは物体の形状に沿って領域を塗り分けるため、より詳細な情報が得られます。さらに発展したインスタンスセグメンテーション(Instance Segmentation)は、同じクラスの物体であっても個別に区別します。

複数の人物が写っている場合、それぞれの人物を異なる色で塗り分けます。そして、これら全てを統合したのがパノプティックセグメンテーション(Panoptic Segmentation)であり、背景などの領域(Stuff)と個別の物体(Things)を同時に識別します。これらの違いを理解することが、適切なタスク選択の第一歩です。

ビジネス価値を生む3つの特徴(精細度・汎用性・拡張性)

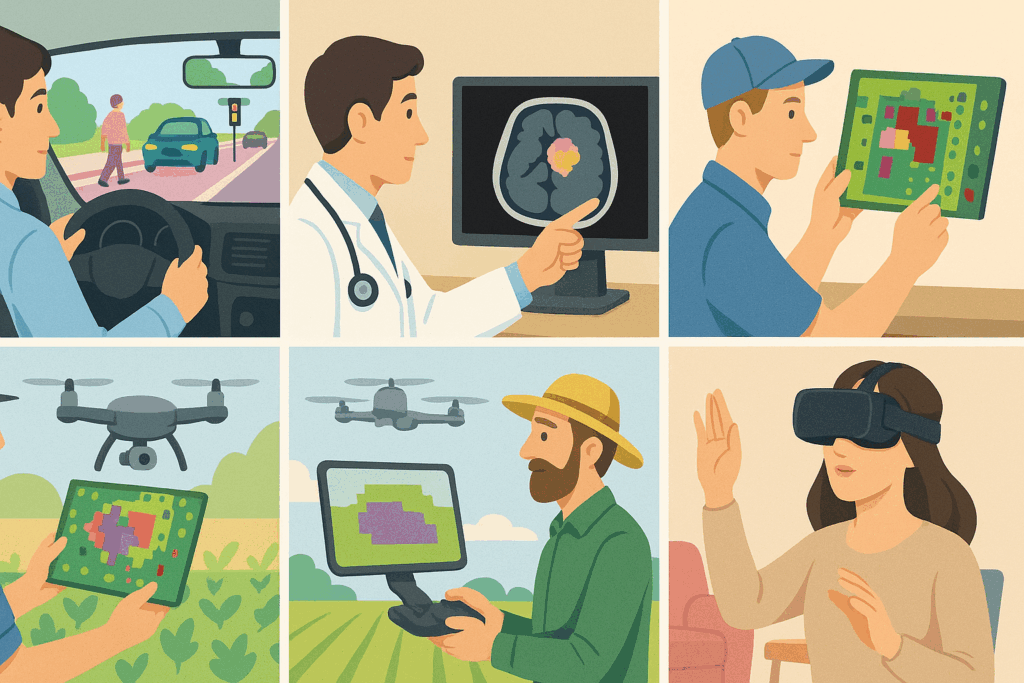

セマンティックセグメンテーションがビジネスで重宝される理由は、その3つの特徴に集約されます。第一に「精細度」です。ピクセルレベルの識別能力は、製造ラインでの微小な欠陥検出や、医療画像からの正確な病変領域の抽出を可能にし、品質向上と診断支援に直結します。第二に「汎用性」です。自動運転から農業、小売、エンターテインメントまで、業界を問わず応用できます。衛星画像を解析して作物の生育状況を把握したり、店内の顧客動線を分析したりと、その活用範囲は広大です。第三の「拡張性」は、他のAI技術との連携を容易にします。AR(拡張現実)で特定の物体にだけエフェクトをかけたり、ロボットが周囲の環境を3次元的に再構築したりと、新たな付加価値を生み出す起点となるのです。

主要評価指標 mIoU・Pixel Accuracy をわかりやすく解説

セマンティックセグメンテーションのモデル性能は、主に「mIoU(mean Intersection over Union)」と「Pixel Accuracy」という2つの指標で評価されます。Pixel Accuracy(ピクセル正解率)は、最も直感的な指標で、全てのピクセルのうち、正しくクラス分類されたピクセルの割合を示します。しかし、画像の大半を占める背景クラスの正解率が高いだけで、全体の精度が高く見えてしまう欠点があります。そこで重要になるのが mIoU です。これは、クラスごとに「予測領域と正解領域の重なり部分(Intersection)」を「予測領域と正解領域を合わせた部分(Union)」で割った値(IoU)を計算し、その平均を取るものです。この指標のおかげで、画像内に占める面積が小さいクラスの性能も公平に評価され、モデルの総合的な精度をより正確に把握することが可能になります。

代表的公開データセット(Cityscapes・ADE20K ほか)の概要

高精度なモデルを開発するためには、大規模で質の高い学習データが不可欠です。セマンティックセグメンテーションの分野では、研究開発を促進するため、いくつかの代表的な公開データセットが広く利用されています。Cityscapesは、ドイツの都市風景を撮影したデータセットで、自動運転技術の研究で頻繁に用いられます。30ものクラスが詳細にアノテーションされており、非常に高品質です。ADE20Kは、屋内から屋外まで多様なシーンを含む150クラスもの大規模なデータセットで、より汎用的なモデルの学習に適しています。その他にも、一般的な物体認識に使われるPASCAL VOCやMS COCOもセグメンテーション用のラベルが付与されており、ベンチマークとして活用されています。これらのデータセットの存在が、技術の進化を支える土台となっているのです。

代表アルゴリズムと最新トレンドを一気に把握

セマンティックセグメンテーションの技術は、深層学習(ディープラーニング)の発展とともに目覚ましい進化を遂げてきました。ここでは、その歴史的な変遷から、現在の主流となっている最先端のモデル、そして今後の動向までを詳しく解説します。

FCN から U-Net・DeepLab まで進化の系譜

セマンティックセグメンテーションのブレークスルーは、2015年に登場したFCN (Fully Convolutional Network) から始まりました。FCNは、画像分類で一般的だった全結合層を畳み込み層に置き換えるという画期的な手法で、任意のサイズの画像を入力とし、ピクセルごとの予測を実現しました。その後、医療画像分野から生まれたU-Netが登場します。U-Netは、一度圧縮した特徴マップを再び拡大する「エンコーダ・デコーダ構造」と、その過程で特徴を連結させる「スキップコネクション」という機構を持ち、細かい領域の情報を失わずに高精細なセグメンテーションを可能にしました。現在、最も広く使われているモデルの一つがGoogleのDeepLabシリーズです。このモデルの強みは、Atrous Convolutionという手法で受容野を広げ、より大局的な文脈を捉える点にあり、これが高い精度につながっています。

Transformer 系 SegFormer/Segmenter が切り拓く高精度化

近年、自然言語処理の分野で大きな成功を収めたTransformerのアーキテクチャが、画像認識の分野にも応用され始めています。セマンティックセグメンテーションにおいても、SegFormerやSegmenterといったTransformerベースのモデルが登場し、従来のCNN(畳み込みニューラルネットワーク)ベースのモデルを凌駕する性能を示しています。これらのモデルは、画像をパッチに分割し、パッチ間の関係性(アテンション)を大局的に捉えることで、複雑なシーンの理解能力を飛躍的に向上させました。特に、遠く離れたピクセル同士の関連性を学習できる点が強みであり、これまで難しかった物体の境界線や細かい部分の認識精度を大きく改善し、新たな高みへと技術を押し上げています。

転移学習・自己教師あり学習で注目のプレトレンドモデル

一から高精度なモデルを学習させるには、膨大な計算資源と大規模なラベル付きデータが必要です。この課題を解決するのが転移学習(Transfer Learning)です。ImageNetのような巨大なデータセットで事前に学習されたモデルを土台とし、特定のタスクのデータで微調整(ファインチューニング)を加えるアプローチによって、少ないデータでも効率的に高い性能を引き出せます。さらに近年では、ラベルなしの大量のデータから画像そのものの特徴を学習する自己教師あり学習(Self-Supervised Learning)が注目されています。この手法で事前学習したモデルは、より汎用的な特徴を獲得しており、転移学習の効果をさらに高めることが期待されています。

軽量モデルとエッジ推論(MobileNetV3、TensorRT 最適化)

セマンティックセグメンテーションの応用先は、潤沢な計算資源を持つサーバーだけではありません。スマートフォンやドローン、車載カメラといったエッジデバイス上でのリアルタイム処理の需要が高まっています。しかし、これらのデバイスは計算能力やメモリが限られています。そこで、精度を維持しつつ計算量を大幅に削減した軽量モデルの開発が進んでいます。その代表格がMobileNetV3やEfficientNetです。これらのモデルは、ネットワーク構造を工夫することで、速度と精度のバランスを最適化しています。さらに、学習済みモデルをNVIDIAのTensorRTのような推論アクセラレータで最適化すれば、エッジデバイス上での推論速度を数倍に高め、リアルタイムでのセグメンテーションを実現できます。

2025 年注目論文とベンチマーク動向まとめ

2025年に向けて、セマンティックセグメンテーションの分野ではいくつかの重要なトレンドが見られます。一つは、大規模基盤モデル(Foundation Model)の活用です。OpenAIのCLIPやMetaのSAM (Segment Anything Model) のように、特定のタスクに特化せず、多様な指示に対応できる汎用的なモデルが登場しています。これらのモデルをセグメンテーションに応用し、より少ないアノテーションコストで高精度なモデルを構築する研究が活発化するでしょう。また、3Dデータや動画データへと対象を拡張する研究も進んでいます。ベンチマークにおいても、従来の静止画だけでなく、より複雑で動的なシナリオを想定した新しいデータセットや評価指標が提案され、技術の進化をさらに加速させていくことが予想されます。

業界別ユースケース ─ “ピクセル理解” が変える現場

セマンティックセグメンテーションのピクセル単位での詳細な画像理解能力は、様々な産業分野で革新的なソリューションを生み出しています。ここでは、具体的なユースケースを挙げながら、この技術が各業界の現場をどのように変えているのかを紹介します。

自動運転・ADAS での道路環境把握と安全性向上

自動運転システムや先進運転支援システム(ADAS)は、セマンティックセグメンテーションが最も活躍する分野の一つです。車両に搭載されたカメラが捉えた映像をリアルタイムで解析し、「道路」「白線」「歩行者」「対向車」「信号機」といった要素をピクセルレベルで正確に識別します。この情報に基づき、車両は自身の走行可能領域を判断し、障害物を回避し、交通ルールを遵守した安全な走行ルートを計画することができます。特に、悪天候や夜間など視界が悪い状況でも、人間の目以上に安定して周囲の環境を認識できるため、交通事故の劇的な削減に貢献することが期待されています。

医療画像診断(腫瘍領域抽出・臓器分割)の精度革新

医療分野では、医師の診断を支援する強力なツールとして活用されています。MRIやCTスキャンといった医療画像を解析し、腫瘍や病変の領域を正確に抽出する技術は、がんの早期発見や進行度の客観的な評価に貢献します。また、手術計画を立てる際には、特定の臓器や血管の形状を3Dで精密に可視化(臓器分割)することが可能です。この精密なデータのおかげで、執刀医はより安全で正確な手術シミュレーションを行えるようになります。人間による目視では見落としがちな微細な異常の検出や、診断のばらつきを低減させる効果も見込まれ、医療の質の向上と医師の負担軽減の両面に寄与しています。

製造業の外観検査と不良品削減への応用

製造業の品質管理プロセスにおいて、製品の外観検査は不可欠な工程です。セマンティックセグメンテーションは、この検査を自動化し、さらに高度化する力を持っています。例えば、電子基板の微細な傷や断線、金属部品の溶接不良、塗装のムラといった欠陥箇所をピクセル単位で正確に特定します。従来の検査方法では難しかった複雑な形状の製品や、多様な種類の欠陥にも柔軟に対応可能です。24時間体制での検査が可能になるだけでなく、人による判断のばらつきもなくなるため、検査精度の安定化と向上につながります。結果として、不良品の流出を防ぎ、生産性と製品品質の向上に大きく貢献します。

衛星・ドローン画像による農業・インフラ点検の高度化

広大な範囲を対象とする農業やインフラ管理の分野でも、セマンティックセグメンテーションは大きな力を発揮します。衛星画像やドローンで撮影した空撮画像を解析し、農地の中から特定の作物が生育しているエリアだけを抽出したり、雑草の繁茂状況をマッピングしたりすることが可能です。この分析結果を基に、肥料や農薬の散布を必要な場所に限定する「精密農業」が実現され、コスト削減と環境負荷の低減へとつながります。また、橋梁や送電線、ダムといったインフラ設備の点検においても、ひび割れや錆などの劣化箇所を自動で検出し、効率的で安全なメンテナンス計画の立案を支援します。

AR/VR・メタバースでのリアルタイム背景合成

エンターテインメント分野、特にAR(拡張現実)、VR(仮想現実)、メタバースにおいても、この技術は欠かせません。ビデオ会議やライブ配信で、人物と背景をリアルタイムで精密に分離し、バーチャル背景を合成する技術は、セマンティックセグメンテーションの一種です。こうした背景合成技術によって、プライバシーを保護しつつ、より没入感のあるコミュニケーションが実現します。ARアプリケーションでは、現実世界の「床」や「壁」、「テーブル」といった面を認識し、その上に仮想的なオブジェクトを自然に配置することができます。メタバース空間内でアバターと現実世界のユーザーの動きを連動させる際にも、人体の部位を正確にセグメンテーションする技術が応用されています。

実践ステップ ─ データ収集からモデル運用までの道筋

セマンティックセグメンテーションのモデルを実際に開発し、ビジネスに導入するためには、計画的なアプローチが必要です。ここでは、データ収集からモデルの学習、そして本番環境での運用に至るまでの一連のステップを具体的に解説します。

アノテーションツール選定と効率的ラベル付け手法

セマンティックセグメンテーションの成否は、学習データの品質に大きく左右されます。この学習データを作成する作業がアノテーション、つまり画像内の各ピクセルに正解ラベルを付与する作業です。この作業は非常に手間がかかるため、効率的なツールを選ぶことが重要です。LabelboxやSupervisely、CVATといった多機能なアノテーションツールは、多角形描画や自動境界線検出などの支援機能を備え、作業を効率化します。また、SAM (Segment Anything Model) のような対話型のセグメンテーションモデルを活用し、大まかな指示から精密なマスクを生成させる半自動アノテーションも有効です。質の高いアノテーションガイドラインを策定し、作業者間で一貫性を保つことも不可欠です。

サンプルサイズ設計とデータ拡張で性能を底上げ

モデルの性能を最大限に引き出すためには、適切な量の学習データが必要です。必要なサンプルサイズは、解決したいタスクの複雑さやクラス数によって異なりますが、一般的には数千から数万枚の画像が必要とされます。しかし、十分な量の実データを収集・アノテーションするのは困難な場合も少なくありません。そこで活用されるのがデータ拡張(Data Augmentation)です。これは、既存の学習データに対して、回転、反転、拡大・縮小、明るさの変更といった処理をランダムに加えることで、擬似的にデータ量を増やす手法です。こうした工夫を通じて、モデルは多様なデータパターンを学習し、未知の状況に対する頑健性(汎化性能)を高めることができます。

損失関数(Cross-Entropy・Dice Loss)の使い分け

モデルを学習させる際、その予測がどれだけ正解から外れているかを測る指標が損失関数(Loss Function)です。セマンティックセグメンテーションでは、主に2種類の損失関数が使い分けられます。Cross-Entropy Lossは、ピクセルごとに分類の誤差を計算する最も一般的な損失関数です。全てのピクセルを平等に扱うため、全体的な分類精度を高めるのに適しています。一方、医療画像のように特定の領域(例えば腫瘍)の検出が重要で、クラス間のピクセル数に著しい不均衡がある場合にはDice Lossが有効です。Dice Lossは、予測領域と正解領域の重なり具合を直接最適化する仕組みのため、不均衡なデータに対しても前景領域の形状を的確に捉える能力に長けています。これらを組み合わせることも有効な戦略です。

モデル学習・ハイパーパラメータ最適化の勘所

モデルのアーキテクチャと損失関数を決めたら、いよいよ学習のフェーズに入ります。ここでは、学習率やバッチサイズ、オプティマイザの種類といったハイパーパラメータを適切に設定することが性能を大きく左右します。学習率は、一度の学習でモデルの重みをどれだけ更新するかを決める重要なパラメータで、大きすぎると学習が不安定になり、小さすぎると収束が遅くなります。これらの最適な組み合わせを見つけるためには、グリッドサーチやベイズ最適化といった手法を用いて、試行錯誤を繰り返す必要があります。また、学習の進捗をmIoUなどの評価指標で監視し、性能が頭打ちになった時点で学習を早期終了させる(Early Stopping)ことも、過学習を防ぎ効率的に学習を進める上で重要です。

本番環境デプロイとモニタリング/継続学習フロー

開発したモデルは、本番環境にデプロイして初めて価値を生みます。デプロイ先がクラウドサーバーなのか、エッジデバイスなのかによって、モデルの最適化手法(量子化や蒸留など)やインフラ構成が異なります。デプロイ後も、モデルの性能を継続的にモニタリングすることが不可欠です。実世界のデータは多様であり、学習データにはなかったようなパターン(ドメインシフト)に遭遇することで、時間と共に性能が劣化する可能性があります。そのため、実際の入力データとモデルの予測結果を定期的に分析し、性能低下の兆候が見られた場合には、追加で収集したデータでモデルを再学習させる継続的学習(Continuous Learning)のフローを構築しておくことが、長期的に安定したサービスを維持する鍵となります。

直面する課題と未来展望 ─ 次世代セマンティックセグメンテーション

セマンティックセグメンテーションは多くの分野で実用化が進む一方、さらなる進化に向けて克服すべき課題も残されています。ここでは、現在の技術が直面する課題と、それらを解決する最新の研究動向、そしてAI全体の進化がもたらす未来像について考察します。

計算コストとリアルタイム性のトレードオフ対策

高精度なセマンティックセグメンテーションモデルは、一般的に巨大なニューラルネットワーク構造を持ち、膨大な計算量を必要とします。この計算コストは、特にスマートフォンや自動運転車などのリソースが限られたエッジデバイス上でリアルタイム処理を行う際の大きな障壁となります。この課題に対し、モデルの構造を簡素化する軽量化技術(MobileNetなど)や、モデルの精度を維持しながら計算量を削減する知識蒸留(Knowledge Distillation)、ネットワークの重みを低ビットで表現する量子化(Quantization)といった研究が活発に進められています。これらの技術を駆使し、精度と速度の最適なトレードオフを見つけることが、応用範囲を広げる上で極めて重要です。

クラス不均衡・ドメインシフトを克服する技術潮流

学習データにおいて、クラスごとのピクセル数が大きく偏るクラス不均衡問題は、セマンティックセグメンテーションの精度を低下させる一因です。例えば、画像の大半を占める「背景」クラスに学習が偏り、まれにしか出現しない「歩行者」クラスの認識精度が低くなることがあります。この対策として、Dice Lossのようにクラスの大きさを考慮した損失関数の利用や、少ないクラスのデータを意図的に多く学習させるサンプリング手法が用いられます。また、学習データと実運用データの性質が異なるドメインシフト問題も深刻です。これに対しては、異なるドメインのデータにも適応できるように学習するドメイン適応(Domain Adaptation)や、より多様なデータで学習して汎化性能を高めるアプローチが研究されています。

Explainable AI とセグメンテーションの可視化手法

AI、特にディープラーニングモデルは、その判断根拠が不明瞭な「ブラックボックス」であることが課題とされています。特に、医療診断や自動運転のように人命に関わる領域では、AIがなぜそのような判断を下したのかを説明できること、すなわち説明可能性(Explainability / XAI)が強く求められます。セマンティックセグメンテーションにおいては、モデルが画像のどの部分に注目して特定のクラスだと判断したのかを可視化する技術(CAM、Grad-CAMなど)が開発されています。このような可視化手法は、モデルのデバッグや性能改善のヒントになるだけでなく、最終的な意思決定者である人間に対して、AIの判断の妥当性を伝え、信頼を醸成するために不可欠な技術です。

合成データ・シミュレーション活用でデータ不足を解決

高品質なアノテーション済みデータを大量に用意することは、時間的にもコスト的にも大きな負担です。このデータ不足問題を根本的に解決するアプローチとして、CG技術を用いてリアルな画像を生成する合成データ(Synthetic Data)の活用が急速に広がっています。シミュレーション環境で生成された画像は、ピクセル単位の正確なラベルが自動的に付与されるため、アノテーションコストがゼロになります。さらに、現実世界では収集が困難な危険な状況(交通事故の瞬間など)や、まれな気象条件のデータを自由に生成できる利点もあります。現在では、実世界のデータと合成データを巧みに組み合わせ、より頑健で高性能なモデルを効率的に開発する研究が進められています。

Foundation Model 時代における“ピクセル AI”の将来像

近年、特定のタスクに特化せず、膨大なデータから世界の多様なパターンを学習した基盤モデル(Foundation Model)がAIの新しいパラダイムを切り拓いています。MetaのSAM (Segment Anything Model) はその一例で、あらゆる物体を指示に応じて切り抜く驚異的な汎用性を示しました。将来的には、このような大規模モデルが“ピクセルを理解するAI”のOSのような存在になる可能性があります。開発者は、巨大な基盤モデルに対して、テキストや簡単な指示を与えるだけで、特定のドメインに特化した高精度なセグメンテーションモデルを迅速に構築できるようになるかもしれません。その結果、AI開発の参入障壁は劇的に下がり、今まで技術が届かなかったニッチな領域にも、セマンティックセグメンテーションの恩恵が広がっていくと期待されます。

まとめ:ピクセル単位の理解が、ビジネスと社会の解像度を上げる

本記事では、セマンティックセグメンテーションの基礎から最新技術、そして未来の展望までを網羅的に解説しました。この技術は、単に画像を認識するだけでなく、その構成要素をピクセルレベルで詳細に理解することで、自動運転の安全性向上、医療診断の精度革新、製造業の品質管理の自動化など、多岐にわたる分野で具体的な価値を創造しています。

アルゴリズムはFCNからU-Net、DeepLab、そしてTransformerへと進化を続け、今後はSAMのような基盤モデルの登場により、さらに開発が加速していくことが予想されます。計算コストやデータ収集といった課題は依然として存在するものの、軽量化技術や合成データの活用といった解決策も次々と生まれています。

セマンティックセグメンテーションは、デジタル世界が現実世界を見る「目」の解像度を飛躍的に向上させる技術です。この詳細な理解力こそが、より高度で、より安全なAIソリューションを実現し、私たちのビジネスや社会が抱える複雑な課題を解決する鍵となるでしょう。