製造業において製品の品質維持は不可欠です。近年、AI外観検査システムが導入され、高速かつ高精度な検査が可能になりました。しかし、特にディープラーニングを用いたAIは判断根拠が不明瞭な「ブラックボックス」という課題がありました。これは、検査結果への不信感、原因特定や改善の困難さ、説明責任の壁となります。

そこで注目されるのが、AIの判断理由を人間が理解しやすい形で示す「説明可能なAI(XAI)」です。本稿では、外観検査におけるXAIの重要性を、基礎知識から導入メリット、主要手法、活用事例、導入手順、将来展望まで、初心者にも分かりやすく解説します。XAIが外観検査現場をどう変革し、製造業DXを加速するのか、その可能性を探ります。

XAIとは何か――外観検査に求められる透明性の基礎知識

AIが下す判定の根拠を人間が検証できる形で提示する技術が「説明可能なAI(XAI)」です。XAIは、入力データから出力に至るまでの処理過程を可視化し、どの特徴がどの程度結果に影響したのかを数値や図で示します。これにより開発者だけでなく現場の検査担当者もアルゴリズムの意図を理解でき、システム全体の透明性と信頼性が飛躍的に高まります。外観検査へXAIを導入することで、単なる自動化にとどまらず、品質保証の強化、不良原因の迅速な特定、そして高信頼性の検査体制構築が可能になります。

外観検査へのAI導入は、効率と精度を向上させましたが、ディープラーニングなどのAIモデルの判断根拠が不明瞭な「ブラックボックス問題」が依然として課題です。本章では、この問題の背景と、それを解決するXAIの基本的な考え方を解説します。

ブラックボックス問題とXAI誕生の背景

現代のAI、特に画像認識に強みを持つディープラーニングは、膨大なデータから複雑なパターンを学習し、非常に高い認識精度を実現しています。しかし、その内部構造は複雑であり、人間が直感的に理解できるような明確なルールに基づいて判断しているわけではありません。この「なぜそのような判断をしたのかが理解できない」という特性が「ブラックボックス問題」です。外観検査の現場では、この問題が以下のような課題を引き起こします。

- 信頼性の欠如: AIが「不良」と判定しても、その理由が不明確な場合、検査員はAIの判断を完全に信用できず、結局自らの目で再確認する必要が生じます。これでは、AI導入による効率化の効果が大きく損なわれてしまいます。

- 改善の困難性: AIが特定の不良を見逃したり、誤って検出したりする原因が不明なため、AIモデルをどのように改善すべきか、どのようなデータを追加で学習させるべきかの判断が極めて困難になります。

これらの課題に対処するため、AIの判断プロセスを人間が理解できる形で「説明」する技術の必要性が高まり、XAIの研究開発が活発になりました。XAIは、AIの判断を透明化し、その過程を可視化することで、利用者がAIをより深く理解し、信頼できるようにすることを目指しています。

外観検査で起こる判断根拠の不透明さ

外観検査では、製品の微細な傷、汚れ、異物、色ムラなど、多岐にわたる欠陥をAIが検出します。これらの欠陥は非常に小さく、かつ複雑な形状を持つことが多いため、AIの判断の重要性は一層高まります。しかし、ブラックボックス型のAIでは、「なぜこの部分を欠陥と判断したのか」、あるいは「なぜこれは良品と判断されたのか」という理由が明確に示されません。

- 判断の確認が困難: AIが「不良」と判定した結果に対し、検査員は「本当に不良なのか?」「どこに不良があるのか?」といった疑問を持ちます。理由が示されないため、検査員は自身の経験や勘に頼ってAIの判断を再確認せざるを得ず、検査全体のスピードが低下します。

- 改善点の特定が難しい: AIが特定の欠陥を誤って検出したり、重要な欠陥を見逃したりした場合でも、その原因がAIの「見方」にあるのか、学習データに偏りがあるのか、モデルの構造に問題があるのかを特定することが困難です。これにより、AIモデルの改善や再学習の方向性が定まらず、多くの時間とコストを要する可能性があります。

- 利用者の不安と不信感: AIの判断理由が不明なため、現場の作業員や品質保証担当者はAIの判断を完全に信用できず、AIシステムに対する不信感が募ることがあります。これは、AI導入の大きな障壁となり、導入後もAIの活用が限定的になる原因となり得ます。

XAIは、このような判断理由の不透明さを解消し、AIの判断プロセスを分かりやすくすることで、外観検査現場におけるAIの信頼性と実用性を大幅に向上させることを目指します。

Explainable AIの代表的手法一覧(LIME/SHAP ほか)

XAIには、AIモデルの判断理由を説明するための多様な手法が存在します。これらの手法は大きく、特定のAIモデルに依存しない「モデルに依存しない(モデルアグノスティック)」手法と、特定のモデルに特化した手法に分類されます。主な手法は以下の通りです。

- LIME (Local Interpretable Model-agnostic Explanations): 特定のデータ(検査対象の画像など)の近傍で、複雑なAIモデルの振る舞いを単純なモデルで近似し、その結果から説明を生成します。あらゆるAIモデルに適用できる点が大きな特徴です。外観検査においては、不良画像に対して、AIがその不良を判断する上でどのピクセルが重要だったかを強調表示し、局所的な判断理由を直感的に示します。

- SHAP (SHapley Additive exPlanations): ゲーム理論の概念を利用し、各特徴量(画像の各ピクセルやセンサーデータなど)がAIの判断結果にどれほど影響を与えたかを数値的に評価します。個々の予測だけでなく、AIモデル全体の動作原理を理解する上でも役立ちます。外観検査では、不良と判定された画像に対し、不良箇所がAIの判断にどの程度影響したかを数値で示し、客観的な判断理由を提供します。

- Grad-CAM (Gradient-weighted Class Activation Mapping): 画像認識で広く用いられるCNN(畳み込みニューラルネットワーク)というAIモデルに特化した手法です。AIが特定のクラス(例えば「不良」)と判断する際に、画像のどの領域に注目したかをヒートマップ(色の濃淡で重要度を示す図)として可視化します。AIが画像上のどの部分を見て判断したのかを直感的に理解できます。

これらの手法はそれぞれ異なるアプローチでAIの判断理由を明らかにしようとしており、外観検査の対象となる欠陥の種類やAIモデルの特性に応じて、適切な手法を選択することが重要です。

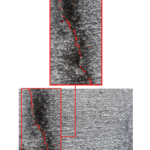

Grad-CAMとHeatmapで見る注目領域の可視化

特に画像を用いた外観検査において、Grad-CAMは非常に有効な手法の一つです。Grad-CAMは、AIが画像を認識する際に、どの領域に注目して判断したのかをヒートマップとして表示します。このヒートマップは、元の画像に重ねて表示され、AIが特に重要だと判断した領域が赤や黄色などの暖色で強調されます。

例えば、AIが製品の微細な傷(クラック)を検出し、不良と判定した場合、Grad-CAMはその傷が存在する部分をヒートマップ上で強く強調表示します。これにより、検査担当者はAIが実際にどの部分を見て不良と判断したのかを一目で確認できます。ヒートマップは、AIの判断の妥当性を検証するのに役立つだけでなく、もしAIが予期せぬ領域(例えば背景のノイズ)に注目している場合には、AIモデルを改善するための貴重な手がかりとなります。このように、Grad-CAMはAIの「見ている場所」を人間と共有することで、AIと人間の連携を深め、検査の信頼性を高めます。

XAIがもたらすユーザーエクスペリエンス向上

外観検査にXAIを導入することは、AIの透明性を高めるだけでなく、システムを利用する人々(検査員、品質保証担当者など)の使いやすさ(ユーザーエクスペリエンス:UX)を大幅に向上させます。AIの判断理由が明確になることで、検査担当者はAIの判断をより深く理解し、納得した上で受け入れられるようになります。

具体的には、以下のようなUXの向上が期待できます。

信頼感の向上

AIが示す判定根拠をヒートマップや重みスコア、類似事例との比較グラフとして提示できれば、検査員は結果と設計許容差との整合性を即座に検証できます。判断の筋道が共有されることでブラックボックス感は大幅に軽減し、現場から品質保証、経営層まで全員がAIの妥当性を納得。信頼を得たAIは改善提案や工程最適化の議論にも参加でき、導入効果が持続的に拡大。さらに監査やトレーサビリティ報告の際も根拠データを提示できるため、外部顧客や認証機関からの信頼も高まり、ブランド価値向上にも直結し、一層強化されます。

業務ストレスの軽減

AIの指示がなぜ出たか分からないまま従う状況は、検査員にとって「結果の押しつけ」を受けている感覚を生み、責任が曖昧なぶん負荷が増します。XAIは判定根拠を可視化し、ロジックを共有します。検査員は自身の経験と照合して確認できるため、疑念が解消され、主体性と自信を回復します。結果として疲労感やストレスが軽減し、モチベーションを保ち高品質な検査が続きます。さらに、根拠データが共有されることでチーム内の対話も円滑になり、個人が判断を背負い込むリスクを減らします。

スキルアップと知識共有

XAIが示す判断理由から、熟練検査員の経験やノウハウがAIによってどのように捉えられているかを学ぶことができ、若手検査員の教育にも活用できます。AIがどのような特徴に注目しているかを理解することで、検査員のスキルアップにつながり、組織全体の知識共有が促進されます。

迅速な意思決定

XAIは入力画像上に異常箇所をハイライトし、確信度と欠陥種別を同時提示します。検査員は追加計測の要否を即断し、合否判定から是正指示までを数秒で完了。基準が可視化されることでシフト間のばらつきも解消し、ライン停止時間を大幅削減します。結果としてスループットが向上し、在庫コストとエネルギー消費が抑制。収集データを即時反映するPDCAが高速化し、生産効率の最適化が持続します。リアルタイム分析で設備異常を予兆検知し、保全計画と連動させることで突発停止のリスクも減少。結果、遵守率が向上し競争力を高めます。

協力体制の促進

AIと人間がそれぞれの得意な部分を活かし、苦手な部分を補完し合う「ヒューマン・イン・ザ・ループ」型の検査体制において、XAIはAIと人間の円滑なコミュニケーションを可能にし、より効果的な協力体制を促進します。

このように、XAIはAIと人間の協働作業を円滑にし、より良い検査体験を提供するための重要な要素となり、最終的には組織全体の生産性と品質向上に貢献します。

AI外観検査導入で得られる5つのメリット

AIを用いた外観検査システムは、従来の人間の目による検査と比較して、多くの利点があります。XAIを導入することで、その効果はさらに増幅されます。ここでは、XAIを組み込んだAI外観検査システムが企業にもたらす6つの主要なメリットを詳しく解説します。

品質保証(QA)強化と欠陥ゼロへの近道

AI外観検査システムは、人間の検査と比較して、疲労や集中力の低下による見落としが少なく、24時間体制で安定した品質の検査が可能です。これにより、検査品質のばらつきが抑制され、不良品が市場に出るリスクを大幅に低減できます。XAIを組み合わせることで、AIが良品・不良品と判断した理由が明確になるため、品質保証担当者はAIの判断を深く理解し、信頼性を高めることができます。例えば、AIが微細な傷を不良と判定した場合、XAIはその傷の位置、形状、周囲の特徴など、AIが注目した具体的な部分を示します。これにより、単に不良を発見するだけでなく、不良品がなぜ発生したのかという根本原因を特定する手がかりが得られます。製造プロセスのどの段階で問題が発生しているのか、どのような条件下で欠陥が発生しやすいのかといった情報をXAIから得ることで、製造プロセスを改善し、最終的には欠陥ゼロの実現に近づくことができます。

ヒューマンエラー削減と省人化効果

人間の目による検査は、検査員の経験、体調、集中力によって検査の質にばらつきが生じやすく、長時間の作業は集中力の低下を招き、人為的なミス(ヒューマンエラー)のリスクを高めます。AI外観検査システムを導入することで、これらの人的ミスを大幅に削減できます。AIは客観的な基準に基づいて判断するため、検査品質が均一になります。さらに、検査が自動化されることで、これまで検査に費やしていた人員を、AIモデルの管理、改善、不良原因の分析、新製品開発など、より付加価値の高い業務に再配置することができ、人手不足の解消やコスト削減にもつながります。XAIによってAIの判断理由が明確になることで、検査結果への信頼が高まり、現場の担当者が安心して自動化を進めることができるようになります。

学習データ拡張による検査精度向上

AI外観検査システムの精度は、学習に用いるデータの量と質に大きく依存します。特に、稀にしか発生しない欠陥(レアケース)や、判断が難しい欠陥については、十分な学習データを収集することが困難な場合があります。XAIを活用することで、AIがどのような特徴を捉えて判断しているのかを人間が理解しやすくなります。これにより、AIが誤認識しやすいケースや、学習データが不足している部分を特定し、効率的に学習データを増やすことができます。例えば、AIが特定の種類の欠陥を見逃しやすい場合、XAIはその原因となる特徴量の不足や、AIが誤って別の特徴に注目していることを示してくれるため、その欠陥の画像を重点的に収集し、アノテーション(ラベル付け)することで、検査精度を大幅に向上させることができます。

不良原因の可視化で改善サイクルを高速化

従来のAI外観検査システムでは、不良品を発見することはできても、その原因を特定することが難しい場合がありました。不良品が見つかっても原因が特定できなければ、製造プロセスを改善することはできません。しかし、XAIを導入することで、AIが不良と判断した理由が明確になるため、不良の原因をより迅速かつ正確に特定できるようになります。例えば、特定の種類の欠陥(例:特定箇所の傷、特定のパターンの汚れ)が頻繁に検出される場合、XAIはその欠陥に関連する製造プロセスのどの部分(例:特定の機械の摩耗、特定の工程での異物混入)に問題があるのかを示唆してくれます。これにより、製造プロセスの改善サイクルを加速させ、不良の発生を根本から抑制することにつながります。

監査・顧客へのエビデンス提示が容易に

製造業では、品質管理に関する厳格な監査や、顧客からの製品に関する問い合わせに対して、客観的で明確な証拠(エビデンス)を提示する必要があります。特に、製品の安全性や信頼性が問われる場面では、その要求は一層厳しくなります。XAIを導入したAI外観検査システムは、単に良品か不良品かを判断するだけでなく、その判断理由を明確に示すことができます。例えば、特定の製品が良品と判断された場合、AIがそう判断した理由や、不良品と判断された場合にAIが注目した部分、その特徴などを画像、数値データ、テキストとして記録に残すことができます。これにより、監査機関や顧客の要求に対して、透明性の高い情報と客観的な根拠を迅速に提供でき、企業の信頼性向上に貢献します。

主要XAI手法の比較と選定ガイド

外観検査にXAIを導入する際には、様々な手法の中から、検査の目的、欠陥の種類、使用するAIモデルの特性に合わせて最適な手法を選択する必要があります。ここでは、主要なXAI手法の特徴を比較し、それぞれのメリット・デメリット、そして選択する際の重要なポイントを詳しく解説します。

SHAP:寄与度を数値化する万能アプローチ

SHAP(SHapley Additive exPlanations)は、ゲーム理論の考え方を応用したXAI手法です。この手法は、各特徴量(例えば、画像の各ピクセルやセンサーデータなど)がAIの判断結果(良品/不良品の確率など)にどれほど影響を与えたかを数値で評価します。SHAP値は、各特徴量の影響度を公平に分配するため、その結果は非常に信頼性が高いとされています。

- メリット:

- 汎用性: ほとんど全てのAIモデルに適用可能です。

- 定量性: 各特徴量の影響度を数値で示すため、客観的な分析が可能です。

- 信頼性: 特定のルールに基づいて計算されるため、信頼性の高い説明を提供します。

- 全体と個別の解釈: 個々の判断理由だけでなく、AIモデル全体の動作原理を理解する上でも役立ちます。

- デメリット:

- 計算コスト: 大量のデータや複雑なモデルの場合、計算に時間がかかることがあります。

- 特徴量間の相互作用: 特徴量同士が強く関連している場合、解釈が複雑になることがあります。

外観検査においては、画像のどの部分やセンサーデータが不良判断に影響したかを数値で示し、客観的な判断理由を提供できます。

LIME:局所的説明で微細欠陥に強い

LIME(Local Interpretable Model-agnostic Explanations)は、「局所的に解釈可能な、モデルに依存しない説明」という意味を持ちます。この手法は、特定のデータ(検査対象の画像など)の「近傍」で、複雑なAIモデルの振る舞いを、より単純で分かりやすいモデルで近似し、その結果から説明を生成します。

- メリット:

- モデル非依存: あらゆるブラックボックス型のAIモデルに適用できるため、汎用性が非常に高いです。

- 個別の説明: 個々の判断に対して、何が最も影響を与えたかを特定するため、微細な欠陥や特定の異常に対する詳細な説明に適しています。

- 直感的な可視化: 画像データの場合、AIがどこに注目して判断したかを画像上の特定の領域を強調表示して視覚的に示します。

- デメリット:

- 説明の安定性: 近似モデルの構築は、データの選択方法によって説明が若干変動する可能性があります。

- 全体像の把握の難しさ: 個々の判断の説明には優れていますが、AIモデル全体の動作原理を理解するには適していません。

外観検査では、AIが微細な傷を不良と判定した場合、LIMEはその傷の周囲の画像領域において、どのピクセルが重要だったかを示し、なぜその部分が不良と判断されたのかを局所的に説明します。

Grad-CAM:CNNモデルの視点をヒートマップで表示

Grad-CAM(Gradient-weighted Class Activation Mapping)は、主に画像認識に使われるCNN(畳み込みニューラルネットワーク)モデルの判断理由を可視化する手法です。この手法は、CNNの内部情報を使って、AIが特定のクラス(例えば「不良」)と判断する際に、画像のどの領域が最も重要だったかをヒートマップとして表示します。

- メリット:

- 視覚的に直感的: ヒートマップで表示されるため、AIが画像のどこを見て判断したのかを人が直感的に理解しやすいです。

- 実装が比較的簡単: CNNモデルに比較的簡単に組み込むことができます。

- クラスごとの注目領域: 特定の不良の種類ごとに、AIが注目した領域を可視化できます。

- デメリット:

- CNNモデル専用: CNN以外のAIモデルには使えません。

- 解像度が粗い場合がある: 生成されるヒートマップの解像度が、元の画像よりも粗くなることがあります。

外観検査では、AIが製品のどの部分を見て不良と判断したのかを直感的に理解できます。例えば、AIが製品の端にある小さな傷を不良と判断した場合、Grad-CAMはその傷の部分がヒートマップ上で強調表示されます。

決定木/ルールベースとのハイブリッド

ディープラーニングのような複雑なAIモデルだけでなく、より分かりやすい決定木やルールベースのシステムとXAI手法を組み合わせる方法もあります。このハイブリッドな方法は、それぞれのモデルの良い点を活かし、苦手な点を補い合うことで、より丈夫で説明しやすいシステムを作ります。

アプローチ例:

- 一次判定にディープラーニング: まず、高性能なディープラーニングモデルを使って、たくさんの製品画像から異常の可能性があるものを速く正確に見つけます。

- 二次分析に分かりやすいモデル: ディープラーニングが見つけた異常候補に対して、より分かりやすい決定木やルールベースのモデルを使って、それが具体的にどんな種類の欠陥なのか、なぜそう判断されたのかを詳しく分析します。例えば、「この傷は、長さがXmm以上で、幅がYmm以上だから不良と判断する」といった具体的なルールを示すことができます。

- XAIによる補足: さらに、ディープラーニングの一次判定の理由をGrad-CAMなどで可視化し、決定木やルールベースの判断と合わせて示すことで、より多角的な説明が可能になります。

このハイブリッドな構成により、ディープラーニングの高性能と、決定木やルールベースの透明性の両方を手に入れられ、複雑な判断過程も段階的に説明できるようになります。

手法選定時の評価指標(精度・処理速度・実装工数)

XAI手法を選ぶ際には、単に説明のしやすさだけでなく、外観検査システムの具体的な目的や条件に合わせて、いくつかの重要な評価項目を総合的に考える必要があります。

- 説明の正確さ(Fidelity): 提供される説明が、AIの実際の判断の仕組みをどれだけ正確に表しているかです。間違った説明は、かえって混乱を招き、AIシステムへの信頼を損なう可能性があります。

- 処理速度(Speed): 説明を生成するのにかかる時間です。リアルタイム性が求められる外観検査システムでは、速い処理が不可欠です。

- 実装にかかる手間(Implementation Effort): XAI手法を既存のAIモデルやシステムに組み込むための労力や技術的な難しさです。既存システムとの連携のしやすさも考慮すべきです。

- 解釈のしやすさ(Interpretability/Understandability): 生成された説明が、現場の担当者など、AIの専門知識がない人にとってどれだけ理解しやすいかです。専門用語を避け、直感的に理解できる視覚的な形式(ヒートマップなど)や、具体的な数値、シンプルなルールで説明できる形式が望ましいです。

- モデルに依存しないか(Model Agnosticism): 特定のAIモデルに依存せず、様々な種類のモデルに適用できるかどうかです。汎用性が高い手法は、将来AIモデルを変更した場合でも、説明手法をそのまま使えるという利点があります。

これらの項目を総合的に評価し、外観検査の具体的な要件や制約(例:検査対象の複雑さ、生産ラインの速度、予算、人材)に合わせて最適なXAI手法を選ぶことが重要です。

製造業DXを加速するXAI活用事例

XAIは、様々な製造業の現場で使われ始めており、品質管理の高度化や生産性向上、そしてデジタル変革(DX)の推進に大きく貢献しています。ここでは、XAIが実際にどのように課題解決に役立っているかの事例をいくつか紹介します。

精密部品の微細欠陥検出システム

精密部品メーカーは、微細なクラックや異物を検出するXAI搭載AI外観検査を導入。AIが不良と判断した際、その根拠となる画像領域を強調表示。検査員はAIが注目した微細な形状変化や異物の存在を容易に理解できます。この透明性により、誤検出の迅速な特定、検査基準の最適化、新たな欠陥パターンの早期発見が可能となり、製品の品質保証レベル向上と顧客からの信頼獲得に貢献しています。

産業機械部品ラインのリアルタイムAI検査

産業機械部品の製造ラインで、高速に流れる部品の欠けや歪みをリアルタイムに検査するシステムにXAIを活用。AIが不良を検出すると、その判断理由を示す情報が作業者に即座に提示されます。特定の箇所に見られるわずかな形状の異常が強調表示されることで、作業者はAIの判断を迅速に確認し、製造ラインの微調整や異常箇所の特定を効率的に行えます。XAIによる判断根拠の可視化は、不良品の早期排除と生産ライン全体の安定化に貢献しています。

食品製造ラインの異物検査と品質管理

ある食品製造企業では、製品への異物混入を防ぐAI検査システムにXAIを導入。検出された異物について、AIがその種類や特定に至った根拠(色、形状、質感など)を説明します。例えば、黒い異物を検出した場合、それが単なる焦げ付きなのか、除去すべき異物なのかを、AIが判断根拠と共に提示することで、検査員の最終判断を支援します。XAIによる透明性の高い異物検査は、製品の安全性を高めるだけでなく、誤検出による無駄な廃棄を減らし、品質管理プロセスの効率化とコスト削減に貢献しています。

インフラ構造物の表面異常検出プラットフォーム

橋梁やトンネルなどのインフラ構造物の老朽化に伴うひび割れや剥離を早期に発見するため、AIを活用した画像解析プラットフォームにXAIが搭載されています。ドローンなどで撮影された構造物の画像からAIが異常を検出すると、その箇所と、AIが異常と判断した理由(ひび割れの形状や深さ、剥離の範囲など)が視覚的に示されます。これにより、点検作業者はAIの判断を効率的に検証し、補修の優先順位付けや詳細な診断に役立てることができます。XAIは、構造物の安全性を維持するための迅速かつ客観的な情報提供を可能にします。

カスタム製品の少量多品種検査におけるAI活用

多種多様なカスタム製品を少量生産する現場において、それぞれの製品特有のわずかな外観不良を検出するためにAIが活用されています。学習データが限られる中で、XAIはAIが不良と判断した根拠となる微細な特徴を可視化します。例えば、特定の部品のわずかな色の違いや、通常見過ごされやすい微小な傷などをAIが検出した場合、XAIはその判断の根拠となる領域を強調表示します。これにより、検査員はAIの判断を理解しやすくなり、限られたデータでもAIの精度向上や、新たな不良パターンの学習に繋げることができます。

XAI導入プロセスと改善ポイント

外観検査にXAIを導入する際には、単にAIモデルを作るだけでなく、その説明性を確保するための計画的な手順と、各段階での改善点が重要です。ここでは、XAI導入の主なステップと、成功させるための具体的なポイントを説明します。

要件定義―検査項目と説明粒度の決定

XAI導入の最初のステップは、何を検査し、AIの判断理由をどの程度詳細に、どのような形式で示すかを明確にすることです。欠陥の種類、許容範囲、必要な説明の細かさ、リアルタイム性などを関係者間で共有し、具体的な要件を定義します。これにより、後の工程での手戻りを防ぎ、プロジェクトを円滑に進めることができます。説明の粒度を適切に設定することは、現場の担当者がAIの判断を理解し、システムを受け入れる上で重要です。

データ収集とアノテーション最適化

AIモデル学習には高品質なデータが不可欠であり、XAIの精度もデータとアノテーションの質に大きく左右されます。良品と不良品のバランスの取れたデータ収集に加え、様々な条件下でのデータを集めることが重要です。アノテーションでは、AIが注目すべき特徴を正確にラベル付けします。XAI導入においては、判断根拠を明確にするためのアノテーション設計が特に重要になります。データ拡張などの技術も活用し、効率的に学習データを準備することが、高精度なXAI実現の鍵となります。

モデル学習・可視化レイヤーの組込み

収集・アノテーションされたデータを用いてAIモデルを学習させ、選択したXAI手法(Grad-CAM、SHAP、LIMEなど)をモデルに統合します。この際、AIの判断理由を分かりやすく表示するための可視化機能(ヒートマップ表示など)を実装します。既存の検査システムや生産管理システムとの連携も考慮し、XAIによる説明結果が現場で活用しやすいように設計することが重要です。モデル設計段階からXAIの組み込みを検討することで、より効果的なシステム構築が可能です。

運用フェーズの継続学習(リトレーニング)

AI外観検査システム導入後も、製品設計や製造プロセスの変更、新たな欠陥の発生などに適応するため、継続的な学習(リトレーニング)が不可欠です。モデルの性能低下(モデルドリフト)を監視し、検査員からのフィードバックを学習データに反映する仕組みを構築します。XAIは、AIが誤検出や見逃しを起こした原因を特定し、再学習の方向性を示す上で役立ちます。自動化された再学習パイプラインを構築することで、効率的なシステム運用が可能になります。

KPI/ROIを測るための指標設計

XAI導入の効果を定量的に評価するため、適切なKPI(検査精度、不良品流出削減率、検査時間短縮率など)を設定し、定期的に測定します。また、導入にかかったコストと得られた効果を比較し、ROI(投資対効果)を評価することも重要です。XAIによる品質向上、コスト削減、業務効率化などの効果を具体的な指標で示すことで、継続的な改善と投資判断に繋げることができます。

規制・ガイドラインと今後の展望

AI技術が急速に進むにつれて、その安全性、信頼性、そして倫理的な側面についての議論が世界中で活発になっています。特に、人の命や社会のインフラに関わる分野、あるいは個人の権利に影響を与える分野では、AIの判断に対する説明責任が強く求められるようになっています。外観検査においても、XAIは将来の規制やガイドラインに対応し、技術革新の波に乗る上で非常に重要な役割を果たすでしょう。

ISO 24029-1 /XAI関連標準の概要

AIシステムの信頼性や透明性に関する国際標準化が進んでいます。ISO/IEC 24029-1はAIシステムの堅牢性を評価する基準を示しており、XAIは堅牢性の問題を診断・改善する上で重要です。XAIに関する具体的な標準化も議論されており、これらの標準はAI開発者や利用者のガイドラインとなり、XAIの導入を促進するでしょう。

産業安全規制とサプライチェーン監査

製造業における産業安全規制は、製品の安全性と品質保証に不可欠です。AI外観検査システムが規制に適合するためには、AIの判断が客観的で検証可能であることが求められます。XAIは、AIの判断理由を明確にすることで、規制当局やサプライチェーン監査において、システムの信頼性と規制遵守を証明する上で重要な役割を果たします。

GDPR/PL法と説明責任の関係

EUのGDPRは、AIの判断が個人の権利や自由に影響を与える場合に説明を受ける権利を示唆しており、各国のPL法は製品欠陥による損害に対して製造者の責任を問います。外観検査におけるAIの誤判断が損害に繋がった場合、XAIは判断過程を説明する重要なツールとなり、企業の法的リスク低減と説明責任遂行に貢献します。

AI Act(EU)動向と国内法制化シナリオ

EUで議論中のAI Actは、AIシステムをリスクに応じて分類し、高リスクAIには透明性などの厳しい要件を課す可能性があります。外観検査システムも用途によっては高リスクに分類される可能性があり、AI Actの動向は各国のAI関連法制化に影響を与えると予想されます。XAIは、これらの将来の規制に対応するための重要な技術となります。

将来技術:マルチモーダルXAIとジェネレーティブAI連携

今後のXAI技術として、画像、音、振動、テキストなど複数のデータを統合して判断理由を説明するマルチモーダルXAIや、AIの判断理由をより直感的に示すためにジェネレーティブAIと連携する技術が期待されます。これにより、より多角的な不良原因の特定や、高度な人とAIの協調が実現する可能性があります

まとめ AIの真の価値を引き出すには、XAIへの戦略的投資と理解が不可欠

製造業の品質保証を変革するXAIは、ブラックボックス型AIの課題を克服し、判断根拠を可視化して信頼性と実用性を向上。品質強化、ミス削減、精度向上、原因特定、監査対応などのメリットがあります。

LIME、SHAP、Grad-CAM等の手法でAIの判断理由を明確化し、多様な産業で活用が進んでいます。導入成功には、要件定義、データ準備、XAI組み込み、継続学習、効果測定が重要です。法規制の動向からもXAIの重要性は増しており、将来的な技術進化も期待されます。

XAIはAIの理解・信頼・改善に不可欠であり、外観検査への導入は製造業DXを加速し、強固な品質管理体制を築く推進力となります。AIの真の価値を引き出すには、XAIへの戦略的投資と理解が不可欠です。