トランスフォーマー(Transformer)は、AI技術の中核を担う革新的なモデルで、自然言語処理(NLP)や画像認識、音声解析などの幅広い分野で大きな役割を果たしています。2017年に発表されたこの技術は、従来のニューラルネットワークモデルの課題を克服し、効率性と性能を劇的に向上させました。トランスフォーマーの誕生背景、基本構造、応用事例、そして未来への可能性について、わかりやすく解説します。

トランスフォーマーの誕生と目的

トランスフォーマーは、Google Brainの研究チームが発表した論文「Attention is All You Need」で提案されたニューラルネットワークアーキテクチャです。このモデルは、特に自然言語処理において広く活用されていますが、その応用範囲はそれを超えています。

背景と従来モデルの課題

従来のRNN(リカレントニューラルネットワーク)やLSTM(長短期記憶ネットワーク)は、順序性のあるデータの解析に特化していましたが、いくつかの課題を抱えていました。

- 逐次処理の非効率性

RNNやLSTMはデータを逐次的に処理するため、並列化が難しく、大規模なデータを扱う際に時間がかかりました。特に長いシーケンス(例:長文)を扱う場合、効率が低下します。 - 長距離依存の限界

文中で離れた単語やフレーズ同士の関係性(例:「彼」と「彼の犬」)を捉えるのが苦手でした。このため、長い文脈を必要とするタスクでは精度が低下する傾向がありました。 - 勾配消失問題

長いシーケンスを扱うとき、ニューラルネットワークの勾配が消失または爆発しやすく、学習の安定性に影響が出ていました。

トランスフォーマーの目標

トランスフォーマーはこれらの課題を解決するために設計されました。特に、以下の点に焦点を当てています。

- 並列処理を可能にして大規模データを効率的に処理する。

- 長距離依存関係を正確に捉え、文脈理解を深める。

- 高速かつ安定したトレーニングを実現する。

トランスフォーマーの基本構造

トランスフォーマーは、エンコーダ(Encoder)とデコーダ(Decoder)の2つの主要な構造から成り立っています。この分割により、データの解析と生成が効率的に行われます。

エンコーダの役割

エンコーダは、入力されたデータを処理し、その特徴を抽出します。たとえば、文章の場合、各単語が持つ意味や位置関係を理解することが主な役割です。

- 入力埋め込み(Embedding)

テキストや画像データを数値ベクトルに変換します。この数値ベクトルは、データの持つ意味や特徴を圧縮的に表現します。 - 自己注意機構(Self-Attention)

データ内の要素間の関連性を計算し、どの部分が他の部分に対して重要であるかを評価します。たとえば、文章中で「彼が飼っている犬」の「彼」と「犬」の関連性を考慮する機構です。 - 位置エンコーディング(Positional Encoding)

順序を直接持たないトランスフォーマーに、データの順序情報を追加します。これにより、文脈の正確な理解が可能になります。

デコーダの役割

デコーダは、エンコーダが抽出した情報をもとに、新しいデータ(テキストや画像など)を生成します。

- マスク付き自己注意

出力の生成時、未来の情報を参照しないように制限する仕組みです。この手法により、正しい順序でのデータ生成が可能になります。 - クロス注意(Cross-Attention)

エンコーダからの情報とデコーダの現在の状態を統合し、文脈に沿った出力を生成します。

トランスフォーマーの応用例

ChatGPTの基盤技術

ChatGPTは、トランスフォーマーの一部であるGPT(Generative Pre-trained Transformer)を基盤にしています。GPTは、膨大な量のテキストデータを学習し、自然な文章生成を行います。具体的には、次のような場面で利用されています。

- カスタマーサポートでの自動応答。

- コンテンツ作成の補助。

- 学習者向けのパーソナライズドな質問回答。

機械翻訳

Google翻訳などのシステムは、トランスフォーマーを使用して文脈を考慮した高精度な翻訳を実現しています。たとえば、言語間での微妙なニュアンスや語順の違いを正確に反映することが可能です。

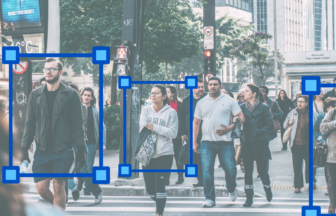

画像処理

Vision Transformer(ViT)は、画像認識にトランスフォーマーを適用したモデルで、従来の畳み込みニューラルネットワーク(CNN)を超える性能を発揮しています。具体例として、医療画像の解析や自動運転車の物体検出があります。

トランスフォーマーの強みと課題

強み

- 並列処理の効率性

従来モデルがシーケンシャルに処理していたデータを、一括で並列処理できるため、計算効率が大幅に向上しました。これにより、大規模なデータを扱うタスクでも高速処理が可能になりました。 - 文脈依存性の理解

自己注意機構により、長い文章の中での単語間の関係性を正確に捉えることができます。この能力は、特に文脈を重視するタスク(翻訳や要約)で大きな利点となります。 - 柔軟な適応性

自然言語処理だけでなく、画像、音声、動画解析といったさまざまな分野に応用できる汎用性を持っています。

課題

- 計算資源の高コスト

トランスフォーマーのトレーニングには、膨大な計算資源とエネルギーが必要です。そのため、大規模モデルのトレーニングには高性能なハードウェアが不可欠です。 - ブラックボックス問題

モデルが複雑であるため、出力結果がどのように導かれたのかを説明するのが難しいという課題があります。 - データの品質依存

トランスフォーマーは大量のデータを必要としますが、そのデータの品質が悪い場合、結果に偏りや誤りが生じる可能性があります。

トランスフォーマーの未来展望

- 軽量化技術の進展

トランスフォーマーの計算負荷を軽減するための研究が進んでいます。これにより、モバイルデバイスやエッジデバイスでの利用が現実化するでしょう。 - 新たな応用分野の開拓

教育やヘルスケア、宇宙探査といった新しい領域での活用が期待されています。例えば、教育では学習者一人ひとりに最適な教材を生成するシステムが考えられます。 - 倫理的な枠組みの構築

トランスフォーマーを悪用したフェイクコンテンツの生成を防ぐための法整備や技術的対策が重要視されています。

トランスフォーマーの可能性

トランスフォーマーは、AI技術の中でも特に大きな可能性を秘めています。その応用は自然言語処理にとどまらず、画像処理や音声解析、さらには教育や医療分野にまで広がりつつあります。計算効率の向上と新しい応用範囲の発展により、トランスフォーマーは未来の技術革新の中心的存在となるでしょう。

実際の活用を通じた発展

現在進行中のプロジェクトでは、トランスフォーマーが気候予測や新薬の開発支援といった高度なタスクにも活用されています。これにより、より複雑で重要な課題にも対応できる可能性が示されています。

トランスフォーマー技術を深く理解することで、その活用の幅をさらに広げることが可能です。これからの技術革新の鍵を握る存在として、私たちの生活やビジネスをより良いものにしてくれることでしょう。